圖、人工智慧最新應用及其法律議題 系列3 -- AI代理 v. 代理AI

本系列上一篇已談到從AI代理到代理AI,這些軟體程式可以在有限的人工監督下,自動化複雜的工作流程,並自主性地決定行動優先順序,來規劃和執行任務、解決問題,其已遠超越聊天機器人的範疇。而在這股技術浪潮中,生成式AI(Generative AI)、AI代理人(AI Agents,下稱AI代理)以及代理型AI(Agentic AI,下稱代理AI),此三者並不相同,但各自扮演不同角色。而其中AI代理與代理AI更是互為糾葛常被混淆,二者聽起來相似,但主要區別在於分工機制。AI代理遵循預先定義的目標來完成單一任務,而代理AI則規劃設定目標的優先順序,並能即時適應並決定如何完成任務。本篇嘗試再詮釋此二者之分野。

一、代理AI之興起

代理AI不局限於內容生成,而是生成式AI的另一種「程式化形式」(programmed form of GAI),邁向自主數位系統(autonomous digital systems);相較於生成式AI對輸入作出回應的「被動型」AI,代理AI則是「主動型」,具備代理之自主性,能根據上下文作出判斷與調整,廣泛應用於需要獨立運作的領域。其重點不僅在於產生內容,而更在於自主行動與決策能力,並將目前數位領域中所執行大部分有意義的工作自動化。

簡言之,代理AI已從單一任務轉向自主執行任務,能主動收集數據、做出決策、採取行動、並根據結果調整其行為、執行多步驟協作流程,不僅可適應不斷變化的外界環境並可與之互動,而且還可以透過API與其他系統互動、應用推理,並根據本人(即委託人)設置的優先順序和規則工作,以實現其目標。因此,代理AI是通用型AI(AGI : Artificial General Intelligence)下一個重要的技術領域,擬將AI轉變為「使用電腦的代理人」(computer-using agents),亦即賦予與電腦、網路和環境互動的能力,從而能達到「人類在電腦前可以做的任何事情」之AI系統。

二、執行者型AI代理 vs. 管理型智慧系統代理AI

AI代理可視為「執行者」(The Doers)角色,有些基於固定規則(傳統型),而有些則由像GPT-4o的LLM所驅動,具備一定程度的適應性。這類代理多為單一代理架構,通常負責採取行動、記憶目標、出錯時重試,猶如一個大腦只專注於一個特定任務。

相對地,代理AI則進化為管理型智慧系統(Intelligent System),若將生成式AI視為「創作者」、AI代理視為「執行者」,那麼代理AI就像是一個能規劃、組織並協調多項AI代理,以完成複雜任務的「管理者」。其不僅執行指令,還會理解目標、拆解任務、指派代理人、監控進度與品質、收集回饋並隨時調整策略。

簡單來說,代理AI是一種整體框架,而AI代理則是構成這個框架的具體單元。代理AI強調在有限監督下解決複雜問題;而AI代理則專注於完成被分配之子任務,這種架構正逐漸改變人類與AI的互動模式。舉例來說,一個智慧家庭能源管理系統,由代理AI負責運行與協調,系統會根據即時數據與使用者偏好,統籌各個AI代理,例如智慧恆溫器、照明系統、家電設備等。這些AI代理各自擁有不同的目標與分工,並在代理AI框架下相互協作,共同實現節能目標。

另一個例子,使用者擬建立一個完整的財務追蹤Web應用,其包括後端API、前端介面、測試、部署與文件撰寫。此時一個AI代理可能難以處理這種複雜需求,而代理AI則依序:

步驟1. 了解使用者的整體目標後,拆分成子任務如UI、API、資料庫、測試;步驟2. 分派給專門的AI代理負責各部分;

步驟3. 確保各AI代理協作並共享上下文;

步驟4. 出現問題時即時修正;

步驟5. 完成並交付最終產品。

這種「多代理人協作」(multi-agent orchestration),即為代理AI的核心價值。

三、深入理解AI代理與代理AI區別

「AI代理」與「代理AI」雖同樣是屬於智慧代理體系的一環,實則在技術架構、運作邏輯與自主性等方面仍有些差異。二者可視為AI發展中的不同階段,從單一任務導向的工具型代理,邁向更具「自主性」的智慧體。

(一)、AI代理:任務導向的自動化工具

AI代理具有上下文感知能力、可以做決策並採取行動來完成任務,而無需持續人工輸入。它不像ChatGPT依賴一問一答的指令,而是根據記憶、邏輯和明確的目標進行操作。此外,AI代理能感知環境、決策分析並採取行動,以實現特定目標的智能系統。常見於已定義好的框架,如強化學習模型、規則導向架構,其運作機制多半包含三個步驟:

步驟1. 感知環境:透過感測器、資料擷取或使用者輸入取得資訊;

步驟2. 依據預設規則或機器學習模型,分析資料並做出決策;

步驟3. 將決策轉為行動,並與環境互動,如控制機器、回應查詢或更新資料等 行為。

雖具一定自主性,但多數AI代理仍需人類監督或設限,且多應用於單一任務或特定領域,例如:客服聊天機器人、虛擬語音助理(Siri、Alexa)、機器人流程自動化系統(RPA)或基礎自駕系統。由於這些系統依賴靜態模型,學習與適應能力相對弱,因此其設計目標大多聚焦在執行單一、重複性或狹義目標的任務上。

(二)、代理AI:協調多AI代理的智慧體

相較之下,由於代理AI表現出更高水平的自主性,因此代理AI通常被視為AI代理的升級版。代理AI可以在沒有持續人工監督的情況下,做出獨立決策並採取行動,使其能夠有效地應對複雜的環境,展現近似人類之推理、規劃、適應與決策能力的系統,並能在多代理系統中協作。反之,AI代理通常遵循預先定義的規則和腳本,這限制了它們自主適應的能力。

一個成熟的代理AI,就像經驗豐富的專業經理人一般,先根據整體任務主動規劃路徑,設定子目標並在情勢變化時靈活調整策略;它結合大型語言模型與多代理架構,進行深度推理與精準決策;在執行過程中,能與其他的AI代理分工協作,彼此共享資訊、互補長短;同時,它不斷透過強化學習與元學習(meta learning)吸收新知,根據環境變化與回饋持續優化自身,讓每一次行動都比上一次更高效、更智慧。

(三)、二者之區別總結

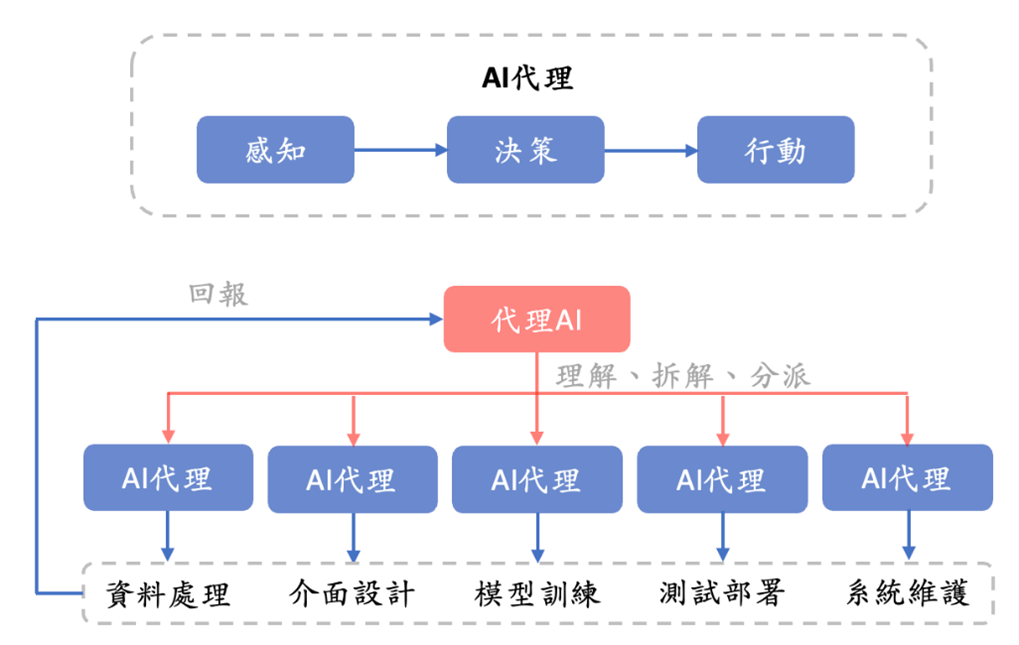

下圖為AI代理與代理AI之間在架構上差異的示意圖。AI代理(圖示中的上層),專注於特定子任務(如資料處理、介面設計、模型訓練、測試部署、系統維護等工作,猶如子計畫經理人)。而代理AI(圖示中的下層),則負責理解使用者目標、拆解任務、分派給不同的AI代理,並持續監控與調整策略。代理AI就像專業經理人,根據各AI代理執行其擅長的任務後回報給代理AI,必要時動態調整任務分配與策略,直到完成整體目標,彼此之間形成一種回饋,充分展現「管理層」與「執行層」之間的分工與互動。雖然二者都建立在類似的技術基礎上(深度學習、大語言模型),但角色、目標與能力完全不同。

圖、AI代理與代理AI之間在架構上差異的示意圖至於工作中要選擇AI代理還是代理AI,這取決於需求場景。若目標是想完成一個具體任務,例如回覆客服問題、處理單筆資料分析,那就選擇AI代理。若需統籌多個流程自動化、跨系統整合或長期自動化運作,尤其是需要調用單一任務之外的不同環境與變數,那麼代理AI就能發揮優勢。這是因為在AI決策方面,代理AI和AI代理之間的區別在於,代理AI採用更細緻的方法,在做出決策之前會評估多個因素和潛在結果。這與AI代理通常遵循一組預先定義的規則,而不考慮更廣泛的影響,形成鮮明的對比。

多數專家預測,未來幾年將出現三者融合的趨勢,即生成式模型(如LLM)將內嵌在智慧代理中,並透過代理型系統負責協調多代理協作,形成兼具創造力、執行力與管理力的智慧,如此AI才能發揮真正的力量。

四、AI代理與代理AI範例:專利申請的角色分工

不論AI代理或是代理AI,在現今的專利申請階段中,已經讓各國企業與相關部門逐漸注意到其應用潛力,不僅可以解決人力資源缺乏與昂貴成本的問題,而且還能大幅提升作業效率並減少人為疏漏。

茲以專利申請為例,在專利申請階段中,不外乎會經歷專利檢索、前案分析、專利說明書撰寫、遞交申請、審查意見通知、核准/核駁、維護等程序,其間過程不僅冗長、繁瑣而且費用昂貴。這時AI代理就可個別擔任專責執行特定重複性工作的助手,例如在專利檢索階段,AI代理能根據預設的關鍵字與IPC或CPC分類號,自動擷取全球公開專利資料,並初步判斷技術相似性;同時,亦可用於定期監控競爭對手的專利申請動態,或是專利維護繳費之狀況。

然而美中不足的是,雖然任務邊界明確,但是較難因應複雜策略或不確定環境下的彈性判斷,例如:無法根據競爭產品的新布局、法規變動、關稅政策或審查意見通知書內容,主動重新安排專利申請策略、調整請求項的保護範圍或重新檢討市場布局。

其主要原因在於,這些工作不只來自單一專利申請任務本身的視角,更涉及其他各面向的判斷。舉例來說,如國家的關稅政策,就必須額外地透過外部Google新聞的API輔助,以調整市場布局規劃;至於為了通過官方審查意見,不僅需要檢索專利資料庫是否有類似的前案,而且還需調用外部的學術期刊資料庫的API,甚至從Web上擷取產品或技術資訊,如此才能有效提升專利申請核准的機率,並能減少與官方的往來答辯的成本。基於此,只能執行單一任務的AI代理,可能就難以面面俱到地處理前述的各項工作。

相較於AI代理,代理AI則更像是一位能協調多個AI工具與任務流程的專業經理人。在一個跨部門的專利申請架構中,代理AI可以主動解析企業的營運目標(如佈局新興技術領域、提高專利價值、保護產品被侵權或避免侵害他人等),並據此規劃任務路徑:包括專利地圖製作、侵權風險評估、可專利性比對、技術價值預測等子任務,並分派給各個AI代理執行。若遇情勢變化,例如競爭對手搶先布局了一個會限制我方後續研發空間的專利,代理AI便能即時調整策略(包括「迴避設計」Design Around),指示AI代理強化布局、提出異議或啟動再審查流程。此系統具備類似人類專家的智慧決策與多代理協調能力,更能適應動態競爭與法規環境的複雜挑戰。

總之,在專利申請階段中,AI代理如同負責單點任務的「技術助理」,專門處理檢索、比對、分析、維護等重複性工作;而代理AI則扮演「策略統籌」的角色,能根據整體營運目標指揮多個AI代理協同運作,並動態調整方向,以因應外部環境與內部策略的變動。更進一步地說,前者需要人類專家定義任務與參數後才開始執行;後者則能主動理解需求、規劃多層任務、協調AI代理並動態調整策略。針對未來智慧化專利運營的場景,AI代理提供執行力,而代理AI則提供系統性智慧決策能力,兩者可互補共同打造自動化與策略並重的專利運營新模式。

五、智慧代理的挑戰與限制

以上所述,係就目前AI現有技術延伸的可能應用方向,儘管各家企業已嘗試推出相關產品,不過迄今仍未見真正成熟且能廣泛落地的成果。再者,各界對「AI代理」或「代理AI」(以下稱「智慧代理系統」)的應用潛能抱持高度期待,然而其發展真的這麼美好嗎?現階段的智慧代理系統在技術、信任、偏見以及法律責任等方面,仍存在諸多挑戰與限制,若將其定位為完全可以取代人類決策與執行的話,恐過於樂觀,茲任舉以下數項亟待克服之課題。

(一)、目標侷限之錯誤決策與失控風險

由於AI代理往往只能處理單一或有限範圍的任務,若遇到複雜或跨領域情境,因功能侷限容易誤判而出現錯誤行動。而代理AI系統係進一步,強調感知、推理、行動的自主性,能在複雜環境中「自己設定目標、執行任務」,但現階段這也可能帶來風險:例如過度自主導致風險;再者,因代理AI可自行優化任務,但也可能因此偏離人類原意,出現失控行為。

智慧代理在處理部分特定任務時確實表現突出,但在自動化決策過程中,仍可能出現嚴重錯誤,尤其在醫療、法律等需要絕對精確性的領域,一個小錯誤也可能造成災難性後果。這凸顯了理論基準與實際應用之間的落差,也說明智慧代理之全面自動化,在現階段仍伴隨風險。

(二)、安全性與「幻覺」問題

AI代理與代理AI多以大型語言模型(LLM)為基礎,而該核心技術本身即存在「幻覺」(hallucination),會生成不存在或錯誤的資訊。當智慧代理於複雜的網路鏈結中運作時,此問題會被放大。代理若基於一錯誤的「幻覺」資訊進行推理,可能引發連鎖性的錯誤決策與行動,不僅導致任務失敗,甚至可能產生危害後果。

此外,賦能智慧代理時常需調用外部工具(如API、資料庫、網頁瀏覽、系統操作等),雖擴展其功能性,卻同時也提高潛在風險。一旦代理因不當提示或內部邏輯錯誤而誤解,便可能執行危險操作,進而造成實質損害。雖然檢索增強生成(RAG)可部分減緩幻覺問題,透過引入外部知識來提高內容正確性,但問題並未根本解決,「幻覺」仍是智慧代理於落地應用時的風險與挑戰。

(三)、工具選擇、任務協調與情境判斷的困境

智慧代理系統的核心在於能執行多步驟的任務,但專家進行「概念驗證」(POC: proofs of concept)時,面臨之常見問題是:智慧代理系統往往難以決定何時應依賴內部知識、何時應選擇和使用外部工具。而智慧代理系統旨在執行任務,但在複雜環境中涉及使用多種工具與數據來源時,AI常難以確定特定情況下之最佳方案為何。

例如,需要做出涉及數據分析和人為判斷的決策,AI可能缺乏精準協調的能力,並會過度依賴一種工具或途徑,而沒有正確整合任務的必要細微差別。當多種工具發揮作用時,這可能會導致工作流程效率低下和判斷錯誤,進而影響任務的可靠性。因此,智慧代理系統在工具運用的靈活性與情境適應方面,與人類相比仍存在顯著差距。

(四)、信任與透明度的脆弱性

AI在黑盒子運作下,因透明度不足讓使用者難以追溯其推理過程,智慧代理中(特別是深度學習模型)仍有許多難以解釋其判斷邏輯,導致透明度與可驗證或解釋性無法到位。而信任更是AI運作能否被廣泛接受的基本前提,人們需要確信AI能提供一致、準確和安全的結果。然而,現有的AI模型無法保證絕對正確,通常一個重大錯誤,就會侵蝕使用者的信任。

以自動駕駛為例,儘管自動駕駛的事故率低於人類駕駛,然而一旦發生死亡事故,仍會引起社會高度質疑。同樣地,若將此邏輯擴展至醫療、金融等攸關人命與財產安全的領域,信任門檻只會更加墊高。試想,一般人會放心服用智慧代理系統開立的藥方?或放心購買其所推薦的基金組合?企業敢將其生成的程式碼部署到生產線上?凡此,AI仍必須與人類協作,以建立高度穩定與透明度,否則公眾難以將關鍵決策交付予智慧代理系統。

(五)、訓練數據集的偏見與歧視

智慧代理系統的最大挑戰之一是確保公平和包容性,但AI的性能常高度取決於其所訓練的數據,而這些海量數據通常是從網路上抓取進行訓練,使得數據本身往往承載著諸多偏見與歧視。若缺乏嚴格篩選調校,這些偏見將在模型中被強化並擴散。以用於招聘的AI代理為例,若依據含有性別或種族偏見的資料訓練,將可能加劇歧視與不平等。這種偏見的可能是毀滅性的後果,影響現實生活並加劇社會不平等。

此外,偏見與歧視問題不易檢測或修復,甚至難以完全消除,即便透過微調與監控,仍可能殘留於模型之中。這顯示AI並非完全中立之工具,其運作深受數據品質影響,也因此在實踐上必須配合透明度與持續的監管。

(六)、人類角色仍不可或缺

雖然AI擅長處理重複、機械化的任務,但在需要判斷、干預周邊情況和遵守道德標準的場景中,人類的介入仍是不可或缺。無論AI再怎麼樣先進,都還是缺乏人類的同理心、直覺和駕馭現實世界複雜性的能力。想像一下,在處理敏感的客服互動或調解工作場所的爭議,智慧代理系統雖能提供基於數據的解決建議,但對於涉及情感上的細微差別和人際關係方面的價值判斷,依然無法取代人類情感與理性之間權衡的智慧。

因此,智慧代理系統在多數情況下,只能被視為增強人類能力的輔助工具,以提升任務的執行效率,但終究還不能取代人類在深思熟慮、合乎道德和富有同理心的決策與判斷之角色。何況,如過度依賴AI,將導致人類之思考與問題解決能力有逐漸退化的風險。

(七)、道德與法律責任歸屬之挑戰

最後,智慧代理系統的落地應用,也可能帶來深刻的道德和法律的挑戰。當AI做出錯誤決策時,究竟是開發者、使用者還是AI系統擁有者的責任?若AI系統被用於惡意操縱輿論、甚至是詐欺或侵犯隱私等違法情況時,法律責任如何界定?這些問題沒有簡單的答案。各國政府與企業需要制定明確的指導方針和法規,來管理智慧代理系統的使用,否則這些系統不受控制地擴散,帶來從侵犯隱私、惡意壟斷到網路攻擊詐騙、深偽等犯罪,可能會導致一系列的不良後果,甚至加劇失業與社會不平等。

AI的發展是把雙面刃,它既能帶來效率與創新,也可能引爆法律與倫理的「潘朵拉魔盒」。隨著這些技術的進步,圍繞著AI相關之權利義務、數據擁有權、安全性和問責制等問題,將變得越來越緊迫。如果沒有保護個人和整個社會的法律與倫理框架,智慧代理系統不僅無法保障自由,反而可能對人類構成威脅。

六、小結

綜上所述,AI代理與代理AI所帶來的智慧代理系統,無疑是一項轉化性的技術創新,但同時也伴隨諸多嚴峻挑戰:從信任危機、數據偏見、到缺乏道德責任和不完美的模型,其缺陷足以在高風險領域引發嚴重後果。尤其是當涉及到取代人類自主決策或執行時,在技術成熟度、工具協調、信任建立、人性需求、偏見矯正以及法律責任等方面,仍存在難以忽視的風險。

這些問題不僅關乎其運作效率,更觸及社會能否安全、可靠地接受其應用。因此,與其將AI視為人類的替代者,不如將其定位為輔助決策與增強能力的工具,是「強化」而非「取代」人類,其發展方向亦應以人機協作為核心。唯有在透明治理、嚴格監管與倫理自覺的共同作用下,AI才能真正成為推動社會進步的力量,而非潛在風險的來源。(6730字;圖1)

作者資訊:

陳家駿律師 台灣資訊智慧財產權協會理事長

許正乾執行長 因子數據股份有限公司共同創辦人

參考文獻:

Generative AI vs Agentic AI vs AI Agents — What’s the Real Difference? Medium,2025/6/2

Agentic AI vs. generative AI. IBM

AI Agents Must Follow the Law. LAWFARE,2025/5/14

Agentic AI vs. AI Agents: Key Differences and Use Cases(2025). Lindy,2025/6/11

AI’s Escalating Sophistication Presents New Legal Dilemmas. NYSMBA,2025/5/28

Can AI Agents Be Trusted? Harvard Business Review,2025/5/26

Law-Following AI: designing AI agents to obey human laws. Institute For Law & AI,2025/5

Addressing Artificial Intelligence Agent Legal Difficulties. Law.Com,2025/4/23

The (Speculative) Rise of AI Agents in Legal. Society for Computer & Law,2025/6/3

Why AI Agents will be a huge disaster Problems with AI Agents. Medium,2025/1/20

Agentic AI vs AI Agents: A Detailed Comparison. Ampcome,2024/12/12

--------------------------------------------------------------------------------------------------------------------------------------------